Il ne nous viendrait pas à l’esprit aujourd’hui en parlant de Google Earth de parler de technologie de géolocalisation. Tout comme lancer une application sur un smartphone ne nous évoque pas immédiatement l’image d’un transistor. De la même manière, dans un futur proche, l’IA ne sera plus une technologie dont tout le monde parle, mais un outil devenu invisible, percolant dans toutes nos activités du quotidien. Les descendants de ChatGPT seront nos compagnons virtuels et nos méthodes de travail et d’enseignement, tout comme nos métiers, s’en verront profondément modifiés.

La perspective d’un tel scénario nous invite évidemment à exercer dès à présent une vigilance collective face à la déferlante de ces outils et à leur utilisation. Réglementation, éducation, esprit critique, ou encore intégrité se doivent d’être nos garde-fous face à cette accélération technologique fulgurante préfigurée par des outils surpuissants à l’image de ChatGPT. L’expérience a démontré qu’un tel engouement pouvait parfois s’accompagner d’un contrecoup violent, à l’image par exemple des vidéos dites deep fake, avancée technologique incroyable en son temps, mais qui a généré plus de méfiance que de bénéfices, contraignant ses créateurs à redoubler d’ingéniosité afin de regagner la confiance du public [1]. C’est l’un des enjeux qui agitent aujourd’hui les experts de tous les domaines de la recherche confondus qui, depuis 2 mois, interrogent et interpellent leurs communautés à grand renfort de messages sur tous les réseaux sociaux, tiraillés entre enthousiasme prudent et critiques argumentées, scepticisme (plus ou moins) bienveillant et mises en garde sur les impacts néfastes en termes de perception de l’IA par le grand public.

Generative Pre-trained Transformers (GPT)

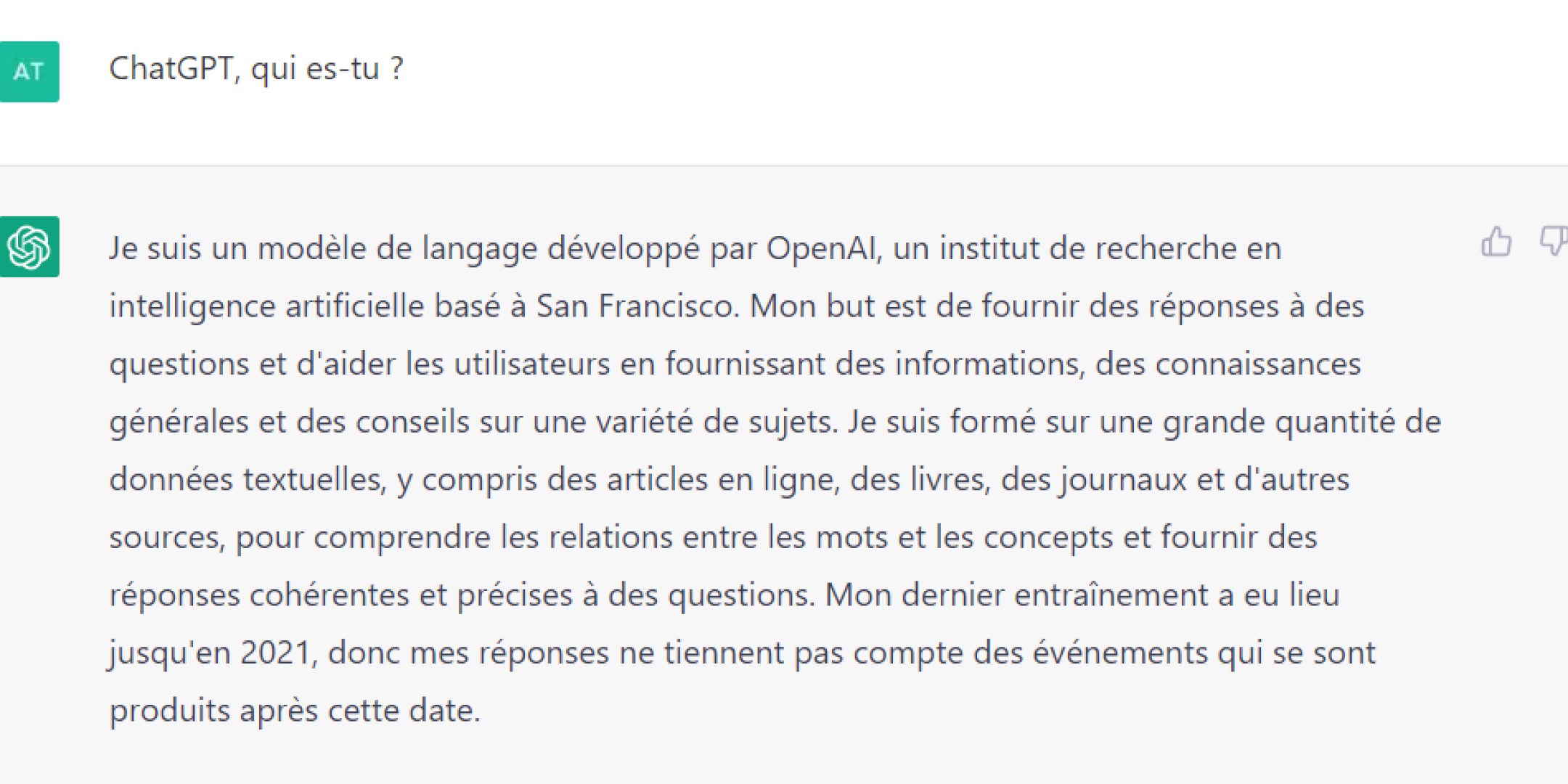

Rappelons tout d’abord quelques éléments de vocabulaire et de contexte. ChatGPT est le dernier né de la famille des transformateurs [2], une technologie démocratisée par Google dès 2016 et qui est une pièce maîtresse dans l’architecture logicielle de ces nouveaux modèles d’intelligence artificielle (IA, AI en anglais). Pour dire les choses simplement, un transformateur est un réseau de neurones qui apprend des éléments de contexte et construit du sens (meaning) en explorant les relations existant entre des données qui se suivent, comme par exemple les mots à l’intérieur d’une phrase.

ChatGPT utilise la technologie de transformateur GPT-3 développée par la société OpenAI, dans sa version 3.5. GPT-3 est un générateur de texte à base d’IA sorti en 2020 : pour la première fois – et bien que cette technologie ne soit pas nouvelle – les utilisateurs découvrent une machine capable d’interagir en utilisant le langage naturel, d’écrire du texte, d’argumenter lors d’une conversation ou encore d’écrire du code, le tout avec une fluidité jusque-là jamais observée.

ChatGPT et ses concurrents appartiennent au domaine de recherche des IA génératives, ou Artificial Generative Intelligence, maladroitement abrégé A(G)I – à ne pas confondre avec Edge AI (“artificial intelligence at the edge”, ou intelligence distribuée), qui se prononce de manière très similaire en anglais, mais décrit pourtant un tout autre domaine technologique et applicatif de l’IA.

Qui est OpenAI ?

A l’origine, OpenAI était une organisation de recherche à but non lucratif, créée en 2015 à l’initiative de plusieurs grandes figures de l’innovation technologique – telles que Elon Musk et Sam Altman – et spécialisée en IA. En 2018, Elon Musk quitte le conseil d’administration. En 2019, OpenAI devient une entreprise à but lucratif plafonné. La vision d’OpenAI est de démocratiser l’IA et de faire en sorte que celle-ci puisse profiter au plus grand nombre, tout en rassurant l’opinion publique sur la maîtrise et le contrôle de cette technologie.

A(G)I : Qui sont les acteurs ?

Google était sans conteste le pionnier de l’IA il y a une décennie. Aujourd’hui, la tendance est dictée par de plus petites sociétés, et en particulier des startups, souvent créées par les anciens experts de Google à l’origine des transformateurs et des modèles de langage naturel (on parle de LLM pour Large Language Models et de NLP pour Natural Language Processing). Hormis OpenAI, on citera par exemple [3] :

- Character.AI : permet la génération d’interfaces de chat individualisé sur la base de descriptions de personnes réelles ou imaginaires; fondée par Noam Shazeer, co-inventeur des transformateurs

- Cohere : startup implantée à Toronto qui conçoit des LLMs sur mesure pour aider les entreprises; co-fondée par Nick Frosst, ancien de Google Brain, et Aidan Gomez, co-inventeur des transformateurs chez Google

- Neeva : interface de chat, fondée par Sridhar Ramaswamy, ancien de Google

- Et aussi : Adept, Inflection.AI, Inworld AI, etc.

La sortie de ChatGPT complique les positions de Google et Meta, qui ont toujours observé jusqu’à présent des politiques prudentes, en particulier en termes de fiabilité de leurs IA, précisément pour éviter la mauvaise publicité qu’une faille pourrait représenter vis-à-vis de l’adoption de ces technologies à très fort impact potentiel [4]. Ces grands de la tech disposent pourtant, parfois depuis plusieurs années déjà, de technologies compétitives qui leur permettraient de rivaliser avec OpenAI.

Google, par exemple, disposait de LaMDA, Flamingo et Meena, des robots conversationnels extrêmement performants, bien avant l’apparition de GPT-3. La politique du géant est pourtant restée la confidentialité, à défaut de pouvoir garantir l’entière fiabilité de ses IA pour une utilisation grand public.

Pourtant, sous l’effet de la pression imposée par ChatGPT, Google, par l’intermédiaire de DeepMind, a annoncé le passage en version Beta en 2023 de son outil Sparrow [5], introduit en septembre 2022. Comme ChatGPT, Sparrow consolide ses règles de sécurité sur la base d’un retour humain (voir le paragraphe “A(G)I : petit récapitulatif technique” ci-dessous pour plus de détails) mais contrairement à ChatGPT, Sparrow peut maintenir à jour ses informations via une connexion directe à internet. Sparrow fait appel au modèle Chinchilla de DeepMind, sorti en avril 2022, qui possède moins de paramètres que les modèles d’OpenAI, mais a été entraîné sur un très grand nombre de données. Chinchilla démontre des performances qui égalent, voire excèdent celles de GPT-3 et Google serait donc en mesure d’égaler ou de dépasser OpenAI dans un futur proche – tout du moins dans l’attente de la sortie annoncée par OpenAI de GPT-4 dans le courant de l’année 2023.

Cependant, il faut bien comprendre que de tels choix stratégiques posent un cas de conscience inextricable à Google. En effet, très rapidement après la sortie de ChatGPT, des voix se sont élevées pour dénoncer la menace pesant sur le moteur de recherche du géant Google. Ceci paraît logique : en lieu et place des centaines de liens à analyser proposés en sortie d’une recherche Google, ChatGPT fournit en réponse à une requête formulée en langage naturel une information pré-digérée, synthétisée, et restituée de manière parfaitement intelligible pour le plus grand nombre. Et bien que “fournir une seule réponse non-sourcée ne permette pas de déterminer si elle est exacte ou fiable” [6], il est probable que la majorité des personnes puissent s’en satisfaire pour répondre à la majorité des requêtes. Ainsi, si Google devait promouvoir un outil concurrent de ChatGPT – et respectant les principes de Google de fiabilité – il est possible que ces nouvelles avancées mettent en péril sa source de revenus la plus importante, à savoir son moteur de recherche. Reste que l’argument de la fiabilité assure encore au moteur Google de beaux jours à venir.

Parmi les autres géants de la tech obligés de revoir leur stratégie, Meta adopte une position très similaire à celle de Google et a introduit en janvier 2023 son nouveau modèle CICERO, une IA conversationnelle collaborative, capable d’élaborer des stratégies d’une extrême complexité [7]. Là encore, la fiabilité est privilégiée par rapport à l’accessibilité, une stratégie orthogonale à celle adoptée par OpenAI et par son tout nouveau partenaire Microsoft.

En effet, à l’opposé de ses alter-ego GAFA, le 16 janvier 2023, Microsoft a renouvelé sa confiance dans OpenAI – Microsoft était déjà un investisseur majeur au lancement de la startup – en proposant d’intégrer à tous les produits de sa suite un accès à ChatGPT et OpenAI par le biais de sa plateforme (son cloud) Azure [8], sous couvert de l’ajout de quelques sécurités complémentaires. L’investissement, dont on spécule qu’il pourrait atteindre 10 milliards de dollars [9], est inégalé à ce jour dans le monde de l’A(G)I et risque de projeter dans une autre dimension – et avec une certaine urgence – les débats qui animent aujourd’hui cette communauté.

A(G)I : une accélération des annonces depuis 2022

Les premiers travaux sur ces modèles LLMs remontent pour certains à deux décennies, mais la course s’amorce réellement en 2014, lorsque Google – alors pionnier de l’IA – acquiert DeepMind et donne accès en 2015 en open source à son algorithme de machine learning TensorFlow. Puis en 2016, c’est la naissance des Transformateurs, toujours par le biais de Google. C’est également cette année-là que Microsoft lance Tay, un chatbot (robot conversationnel) capable de converser sur les réseaux sociaux en apprenant à partir des discussions de ses interlocuteurs. Microsoft se voit dans l’obligation de retirer Tay après moins d’une journée de fonctionnement, après que des utilisateurs malveillants l’ont amené à formuler des arguments s’apparentant à une incitation à une guerre de races. Microsoft remplace alors Tay par Zo quelques mois plus tard. Zo reste actif jusqu’en 2019, mais souffre d’un manque d’intérêt lié à des mesures de sécurité excessives, qui lui imposent de se soustraire à toutes les discussions abordant des sujets pouvant faire l’objet de controverses (races, religions, etc.).

Depuis cette époque, la communauté scientifique a fait des progrès constants et les fondements de l’A(G)I et de ses modèles ont été largement relayés dans les publications à caractère scientifique. Les annonces marquantes sont alors plutôt devenues l’adage de plus petites sociétés ou groupes de recherche au fil de la décennie, jusqu’à l’année 2022 qui marque un tournant pour les IA génératives.

- Juillet 2022 : OpenAI lance DALL-E2, seconde version de DALL-E lancé en janvier 2021. Ce robot, utilisant également GPT-3, permet de générer du contenu graphique à partir d’entrées formulées en langage naturel. DALL-E2 est le premier outil d’A(G)I mis entièrement à la disposition du grand public, et le succès rencontré est immense. Dès l’été 2022, DALL-E2 a quelques concurrents sérieux, parmi lesquels Stable Diffusion, produit de la société Stability AI, basée au Royaume Uni, et qui utilise des modèles de nature différente [10].

- Août 2022 : Meta lance Blenderbot, qui ne remporte pas l’adhésion du grand public, du fait notamment d’un excès de mesures de sécurité qui le fait se soustraire à un certain nombre de requêtes (ex. questions religieuses), au même titre que le Zo de Microsoft précédemment. Pour autant, Blenderbot se retrouve sous le feu des critiques après avoir formulé des commentaires jugés racistes. Meta décide cependant de le maintenir.

- Août 2022 : Google ouvre un accès restreint au grand public à LaMDA, son IA utilisant également le langage naturel. La puissance et la robustesse de cette IA sont telles qu’elles ont procuré chez certains de ses créateurs le sentiment que l’IA avait effectivement une conscience [11] – une affirmation qui tend à soutenir l’argument de la prudence dans les rangs des dirigeants de Google.

- 15 Nov 2022 : Meta lance Galactica, un robot capable de collecter l’information scientifique et faciliter la rédaction de travaux scientifiques, par le biais du langage naturel. Cette fois, Meta retire son produit au bout de 3 jours suite à des critiques concernant imprécisions et biais du modèle dans sa restitution de résultats scientifiques, et allant jusqu’à la création de contenu sans aucun sens sur le plan scientifique. Un exemple de plus montrant que la stratégie de la fiabilité se justifie.

- 30 Nov 2022 : OpenAI lance ChatGPT, qui, bien qu’il rencontre des failles de fiabilité similaires à ses prédécesseurs, propose une fluidité et une aisance conversationnelles telle qu’il est immédiatement adopté par des millions d’utilisateurs de par le monde, et loué pour sa capacité à traiter toutes sortes de problèmes et à construire des raisonnements pas à pas convaincants – bien que parfois complètement erronés. Ses erreurs sont pointées du doigt mais ne sont pas un frein à la curiosité des utilisateurs, qui n’en finissent pas de tester ses limites, contribuant ainsi à renforcer son apprentissage.

A(G)I : petit récapitulatif technique

Inspiré d’un article de HuggingFace paru fin janvier [12], le tableau ci-dessous – loin d’être exhaustif – permet de dresser un récapitulatif des grandes tendances en matière de modèles et d’outils lorsqu’il s’agit de comparer les différentes technologies d’A(G)I et les stratégies des différents acteurs.

| ChatGPT | LaMDA | BlenderBot | Sparrow | |

| Société | OpenAI | Meta | DeepMind (Google) | |

| Accessibilité au grand public | Ouvert | Partiel | Ouvert | Fermé |

| Modèle utilisé | GPT-3 (version 3.5) | Non divulgué | OPT | Chincilla |

| Taille du modèle (nombre de paramètres) | 175e+9 | 137e+9 | 175e+9 | 70e+9 |

| Taille de la base | Non-divulguée | 2810e+9 | 100e+9 | 1400e+9 |

| Le modèle a accès à internet | Non (la base s’arrête en 2021) | oui | oui | oui |

| Sécurité par le biais de règles pré-établies | non | oui | non | oui |

| Sécurité renforcée par un retour humain (Reinforcement Learning by Human Feedback) | oui | non | non | oui |

| Critère de succès du modèle privilégié | Utilité de l’info

Sécurité (biais) |

Qualité de l’info

Sécurité (biais) Vérifiabilité |

Qualité de l’info

Sécurité (biais) |

Utilité de l’info

Sécurité +++ Vérifiabilité Fiabilité |

Quelques points saillants :

- Un concept bien répandu est qu’une IA n’est jamais aussi intelligente que le jeu de données sur lequel elle a appris. Les biais sont donc induits par la base et le principe consistant à établir des règles pour les contourner n’est qu’une solution “de secours” qu’il reste facile de prendre à revers.

- Les deux approches concurrentes pour la régulation de la sécurité sont (i) l’établissement de règles fixes pré-établies et codées “en dur” par les constructeurs du modèle, ou (ii) l’approche RLHF (pour Reinforcement Learning by Human Feedback), qui consiste à renforcer l’apprentissage sur la base d’une évaluation du critère de réussite par l’humain (la tâche a ou n’a pas été réalisée correctement). La première peut induire un refus de répondre à certaines questions ne respectant pas les règles établies. La seconde permet d’apprendre à créer du contenu modéré face à tout type de requêtes, mais laisse la place à d’éventuels contournements des règles de sécurité. L’apport d’une combinaison des deux approches, comme c’est le cas dans Sparrow, n’a pas encore été démontré à ce jour.

- Le concept de chaîne de pensées (Chain-of-thought, CoT), ou raisonnement pas à pas, décrit la capacité d’un modèle à élaborer, à partir de la discussion, des réponses dans les situations où, en théorie, il serait dans l’incapacité de répondre. C’est l’un des atouts de ChatGPT qui a suscité le plus d’enthousiasme auprès du grand public. Cette approche permet, entre autres, de faire progresser le modèle malgré une base initiale qui ne grandit plus (ChatGPT ne peut pas mettre à jour ses informations par le biais d’internet). Elle est également une solution partielle à “l’oubli catastrophique”, ce concept selon lequel lorsqu’on modifie la base de données sur laquelle le modèle apprend, alors le modèle doit réapprendre depuis le début, oubliant parfois de manière catastrophique toutes les informations qu’il avait enregistrées par le biais de l’apprentissage renforcé, par exemple. Ceci explique en particulier que ChatGPT ait été ouvert au grand public, ce qui lui confère une source très large de nouvelles informations (non vérifiées ou vérifiables cependant).

- Enfin, les détracteurs de ChatGPT disent souvent qu’OpenAI n’a rien inventé : en effet, ChatGPT est conçu sur des modèles et algorithmes qui sont essentiellement accessibles en open source. C’est d’ailleurs ce qui lui permet aujourd’hui d’établir les accords que nous avons évoqués avec Microsoft. Malgré la réussite technologique derrière cet outil, c’est donc bien son accessibilité au grand public qui fait aujourd’hui son originalité.

Limites de ChatGPT : Performance et fiabilité

Pour conclure ce tour d’horizon assez général sur les limitations techniques et perspectives de développement de ChatGPT, intéressons-nous à deux aspects techniques des LLMs qui mobilisent aujourd’hui l’attention des chercheurs.

Premièrement, l’incapacité des IA à comprendre le monde qui les entoure. Il s’agit de l’un des sujets de prédilection du très renommé Yann LeCun, lorsqu’il développe sa vision des machines intelligentes autonomes [13]. C’est également, à ce jour, la barrière infranchissable entre l’IA et l’humain. L’une des raisons pour lesquelles ChatGPT peut restituer de manière très convaincante des affirmations qui sont pourtant complètement erronées, voire inexistantes, est qu’il fait référence à une information “compressée”, parfois lacunaire, imposée par la taille de la base et le nombre de paramètres utilisés pour entraîner le modèle. Pour expliquer ceci simplement : il n’a pas la capacité à la fois d’apprendre, de restituer et de mémoriser [14,15].

Deuxièmement, et ceci découle du point précédent, ChatGPT ne possède aucune capacité computationnelle. Par exemple, ChatGPT saura vous donner la distance entre 2 villes du monde sur la base de la documentation dont il dispose, mais sera incapable de mesurer cette distance à partir des coordonnées géographiques de ces 2 lieux (qu’il connaît pourtant). Si sa base est erronée, sa réponse sera donc erronée. De même, s’il doit comparer 2 nombres spécifiques (par exemple la surface de 2 pays) et les classer, il ne sera en mesure de le faire que si ce classement est déjà disponible dans sa base. Et parfois obtiendra la mauvaise réponse (bien qu’il connaisse, a priori, la suite numérique !). C’est ce qui explique que ChatGPT, bien qu’il soit capable de restituer tous les théorèmes existants et de suivre un raisonnement pas à pas, soit un très mauvais élève en mathématiques, en particulier. En effet, ChatGPT n’a pas la capacité de comprendre ses propres raisonnements, ce qui l’amène souvent à commettre des erreurs d’une manière qui le rend étonnamment… humain. Ces failles identifiées dans ChatGPT pourraient décrédibiliser l’IA auprès du grand public ou minimiser la prouesse technique. A ce sujet, Stephen Wolfram propose une analyse extrêmement instructive – et détaille les exemples mentionnés – dans son article daté du 9 janvier [16], dans lequel il explique comment la combinaison de l’approche linguistique avec l’approche computationnelle, rendue possible par le fait que ChatGPT et Wolfram|Alpha utilisent tous les deux le langage naturel en entrée et en sortie, ce qui leur permet de “communiquer” ensemble, est une perspective technologique presque infinie pour l’A(G)I. Le second corrige les failles du premier, qui les intègre sans difficulté. L’exemple de la requête “calculer le nombre de calories dans une année lumière cubique de crème glacée” est parlant : Wolfram|Alpha ne questionne pas le sens de la question et réalise le calcul mathématique, tandis que ChatGPT refuse de répondre, prétextant que l’objet en question ne peut être conceptualisé. Comme cela n’existe pas, ce n’est pas référencé stricto-sensu dans la base de ChatGPT, qui ne peut donc pas le restituer. Il peut en revanche argumenter sur le fait que ça n’est pas concevable. La conclusion de Wolfram comme quoi ChatGPT n’est pas parfait car il n’est finalement qu’humain ne manque pas d’ironie.

En gage de perspective, cet article et toutes ces références nous laissent à réfléchir sur les futurs développements de l’A(G)I. Faut-il continuer à entraîner les modèles sur des réseaux toujours plus grands, alors même que le seul concept d’irréductibilité computationnelle rend impossible le fait de progresser de cette manière à l’infini ? Et qu’un travers catastrophique serait de chercher à développer des outils toujours plus performants au risque de se perdre dans l’attrait de la technologie pure, au détriment du concept de right tech? L’émergence de nouveaux paradigmes et de ruptures technologiques permises par les chatbots est une voie plus crédible, mais incertaine. Quant à mener ces deux axes de recherche de front, il est probable que cela engendre une consommation de ressources – économiques, environnementales et humaines – que notre société et notre planète ne pourront pas soutenir très longtemps.

Enfin le concept de compagnonnage et “d’IA-tutorat” [17] gagne du terrain parmi la communauté, ce concept selon lequel l’IA ne remplacera jamais l’homme, mais que l’homme d’aujourd’hui sera surpassé par l’homme utilisant l’IA pour augmenter ses propres capacités [18]. A l’image d’autres chercheurs, Wolfram utilise depuis plus d’une décennie son outil Wolfram|Alpha pour l’aider à résoudre plus vite des problèmes computationnels complexes. Il devient alors naturel de penser l’IA comme outil de transformation de nos métiers. Ce sujet passionnant et d’un intérêt brûlant pour l’ensemble des communautés concernées fera l’objet d’un futur article.

Dans les prochaines épisodes de “La Saga A(G)I”…

Au fil des prochains mois, nous vous proposerons d’élargir ce premier tour d’horizon aux problématiques suivantes, liées à l’A(G)I et à son hypothétique adoption à grande échelle :

- Éthique et responsabilité de l’IA : quel impact sur l’autorat et la propriété intellectuelle ? Sur nos sociétés actuelles ? Avec quel degré d’inclusivité ? Manipulation de l’opinion publique (désinformation, propagande) et approche philosophique de l’éthique de l’IA.

- Adoption de l’A(G)I dans les différents secteurs d’activité (éducation, industrie, tech grand public, médecine, climat, défense) : comment l’A(G)I transforme nos métiers ?

Où rencontrer la communauté A(G)I ?

Au-delà des podcasts toujours très nombreux sur internet et qui alimentent les divers débats autour de l’A(G)I, le mois de janvier a vu se tenir un grand nombre d’événements nouveaux pour cette communauté de chercheurs, en particulier dans la Silicon Valley, et on ne doute pas que cela se poursuive dans les mois à venir.

Le 26 janvier 2023 avait lieu le webinaire organisé par C3.ai sur le thème “Solve Supply Chain Challenges with AI” (accessible sur demande)

Le 27 janvier se tenait la conférence Philosophy, AI and Society (PAIS) à l’université de Stanford, sur le thème de la régulation et l’IA et de l’éthique de l’IA dans son approche philosophique.

Les vidéos du AGI Debate organisé périodiquement par Montreal.AI sont également disponibles en ligne sur YouTube et mobilisent des grands noms de la communauté scientifique pour parler de sciences cognitives, d’architectures d’IA, mais également aborder les questions d’adoption de l’IA, d’éthique et de régulation.

Enfin le 14 février 2023 se tiendra à San Francisco la toute première conférence dédiée à l’A(G)I, Gen AI, en présence une dizaine d’orateurs de renom.

Rédactrice : Emmanuelle Pauliac-Vaujour, attachée pour la science et la technologie au consulat de France de San Francisco, [email protected]

Références :

[1] Vidéo : Creating a « lie detector » for deepfakes – YouTube (29 janvier 2023)

[2] Article : Les transformateurs, expliqués : Comprendre le modèle derrière le GPT-3, le BERT et le T5 – Bravrez.fr

[3] Article : Google and Meta moved cautiously on AI. Then came OpenAI’s ChatGPT – The Washington Post (27 janvier 2023)

[4] Article : Google’s Big Fear Is AI Running Wild. It’s Too Late to Stop It – Businessinsider.com (19 janvier 2023)

[5] Article : Google may use Deepmind’s Sparrow as ChatGPT competitor – The Decoder (14 janvier 2023)

[6] Article : ChatGPT : Pourquoi le robot conversationnel d’OpenAI bouleverse autant la Silicon Valley – 20minutes.fr

[7] Post (vidéo) : LinkedIn – MetaAI (12 janvier 2023) ; voir aussi le site https://ai.facebook.com/research/cicero/

[8] Article : Microsoft Plans to Build OpenAI ChatGPT Features Into All Products – WJS (17 janvier 2023)

[9] Article : Microsoft Confirms Its $10 Billion Investment Into ChatGPT, Changing How Microsoft Competes With Google, Apple And Other Tech Giants – Forbes.com (27 janvier 2023)

[10] Article : Stable Diffusion – Wikipedia

[11] Article : Non, l’intelligence artificielle de Google n’est pas consciente, comme l’affirme un ingénieur de l’entreprise – 20minutes.fr (15 juin 2022)

[12] Article : What Makes a Dialog Agent Useful? – Huggingface.co (24 janvier 2023)

[13] Article : A Path Towards Autonomous Machine Intelligence | OpenReview (27 juin 2022)

[14] Article : The Problem with Teaching Language Models about the World | by Josua Krause | Medium (7 janvier 2023)

[15] Article : The Brilliance and Weirdness of ChatGPT – The New York Times (5 décembre 2022)

[16] Article : Wolfram|Alpha as the Way to Bring Computational Knowledge Superpowers to ChatGPT – Stephen Wolfram Writings (9 janvier 2023)

[17] Article : ChatGPT : Pourquoi le robot conversationnel d’OpenAI bouleverse autant la Silicon Valley – 20minutes.fr (13 janvier 2023)

[18] Post : LinkedIn – Gregory Renard – Impacts of AI: Mitigating the risks of professional obsolescence through lifelong learning and Universal Basic Income policies (14 janvier 2023)